Softmax와 Sigmoid 차이점 완벽 정리! 딥러닝 함수 비교

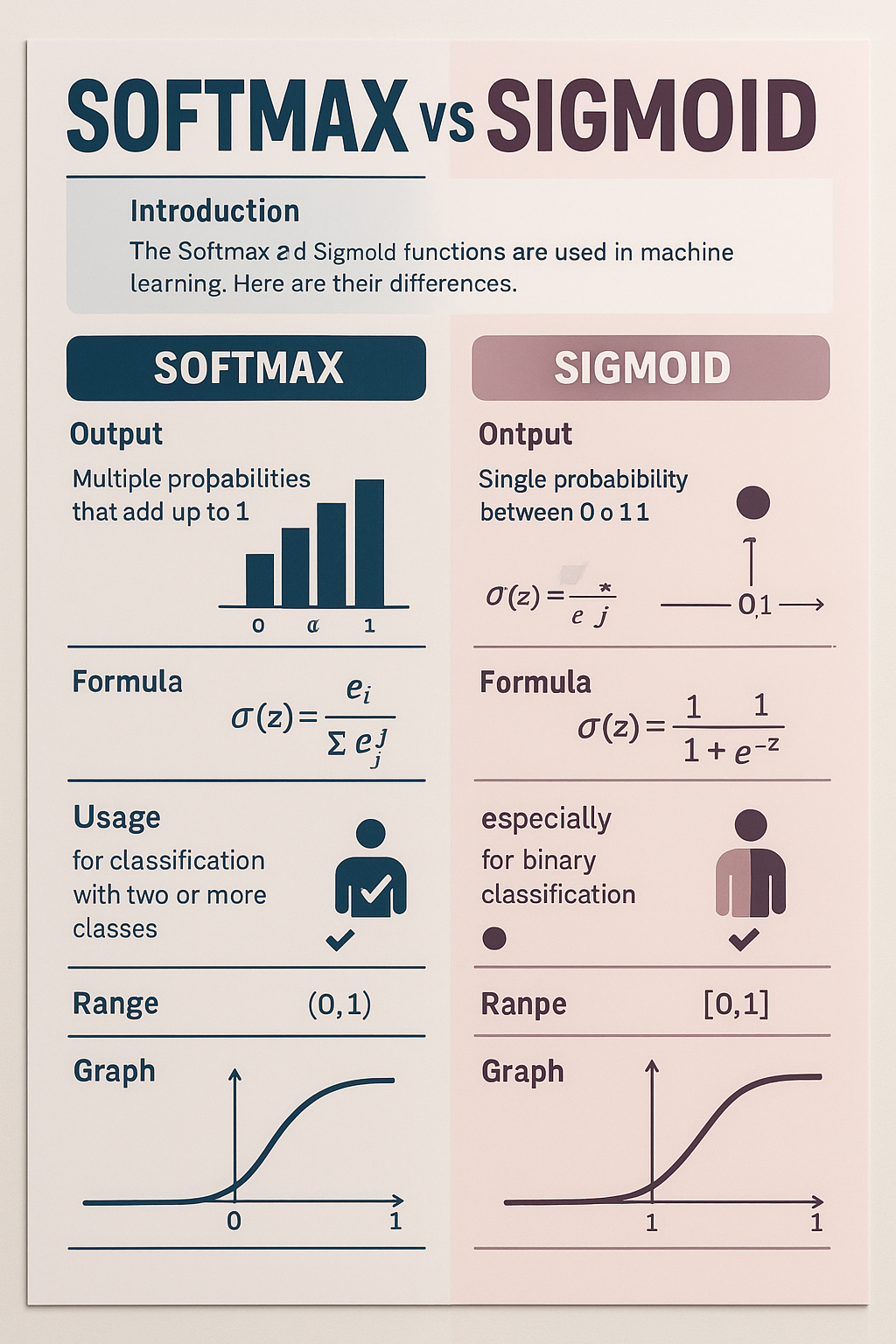

딥러닝이나 인공지능에 사용되는 SOFTMAX 함수와 SIGMOID 함수의 차이점에 대해서 알아 보겠습니다. .

이 두 함수는 기계가 똑똑해지기 위해 꼭 필요한 수학 도구인데요, 이름만 들으면 어렵게 느껴집니다.

글 까지 읽으시면 SOFTMAX와 SIGMOID가 무엇인지, 왜 다른지, 언제 쓰는지까지 알게 되실 겁니다.

1. SOFTMAX와 SIGMOID는 무엇인가요?

먼저 SOFTMAX와 SIGMOID는 딥러닝 모델에서 결과를 계산해주는 함수입니다.

딥러닝은 기계가 데이터를 보고 똑똑하게 판단하도록 도와주는 기술인데요, 마지막에 기계가 ‘이게 맞는 답인가요?’ 하고 결정할 때 SOFTMAX나 SIGMOID가 도움을 줍니다.

- SIGMOID 함수는 하나의 값(숫자)을 받아서 그 값을 0과 1 사이의 숫자로 바꿔줍니다. 예를 들어, 기계가 ‘이 사진은 고양이다’ 아니면 ‘고양이가 아니다’를 판단할 때 SIGMOID를 씁니다.

- SOFTMAX 함수는 여러 값을 받아서 각 값이 맞을 확률을 계산해줍니다. 예를 들어, ‘이 사진은 고양이인가, 강아지인가, 토끼인가?’ 처럼 여러 가지 중에 하나를 고를 때 SOFTMAX를 씁니다.

2. SOFTMAX와 SIGMOID의 작동 방식 비교

이제 두 함수가 어떻게 다르게 계산하는지 아주 쉽게 풀어볼게요.

SIGMOID 작동 방식

SIGMOID는 하나의 숫자를 받아서 그 숫자가 0과 1 사이로 바뀌게 합니다. 숫자가 아주 크면 1에 가까워지고, 숫자가 아주 작으면 0에 가까워집니다. 즉, 참일 확률을 나타내는 것처럼 보이게 만들어 줍니다.

예시)

- 큰 값 입력 → 0.99 같은 큰 확률

- 작은 값 입력 → 0.01 같은 작은 확률

SOFTMAX 작동 방식

SOFTMAX는 여러 숫자를 동시에 받아서 각 숫자가 전체에서 어느 정도 비율을 차지하는지 계산합니다. 모든 결과의 합이 1이 되게 맞춰줍니다. 이건 마치 여러 후보 중에 하나를 고르는 확률처럼 작동합니다.

예시)

- 고양이: 0.7, 강아지: 0.2, 토끼: 0.1 → 고양이일 확률 70%

3. SOFTMAX와 SIGMOID의 주요 차이점

SOFTMAX와 SIGMOID는 목적이 다릅니다. 한눈에 볼 수 있도록 표로 정리해보겠습니다.

| 구분 | SOFTMAX | SIGMOID |

| 사용하는 상황 | 두 가지 중 하나를 고를 때 | 여러 가지 중 하나를 고를 때 |

| 출력 값 | 0과 1 사이의 값 | 각 클래스의 확률, 합이 1 |

| 출력 값 개수 | 클래스마다 독립적으로 1개씩 | 여러 클래스 전체 확률 한 번에 계산 |

| 주 용도 | 이진 분류 | 다중 클래스 분류 |

중요한 차이점

SIGMOID는 각 클래스가 맞을지 아닐지를 독립적으로 봅니다. SOFTMAX는 모든 클래스 확률을 동시에 계산해서 한 클래스의 확률이 올라가면 다른 클래스의 확률은 내려갑니다.

4. SOFTMAX와 SIGMOID는 어디서 쓰이나요?

SOFTMAX와 SIGMOID는 딥러닝에서 쓰임새가 다릅니다.

- SIGMOID 사용 예

- 스팸 메일인지 아닌지 구분할 때

- 개냐 아니냐를 보는 이진 분류

- SOFTMAX 사용 예

- 숫자 이미지(0~9)를 분류할 때

- 고양이, 강아지, 토끼 사진 중 무엇인지 맞출 때

- 손글씨 인식처럼 여러 클래스가 있는 문제

이처럼 문제의 성격에 따라 함수를 골라 씁니다.

5. SOFTMAX와 SIGMOID 선택 시 주의할 점

SOFTMAX와 SIGMOID를 쓸 때 주의할 점이 있습니다.

- 문제의 종류를 먼저 확인하세요.

- 두 가지 중 하나를 고르는 문제는 SIGMOID가 적절합니다.

- 여러 가지 중 하나를 고르는 문제는 SOFTMAX가 적절합니다.

- 출력 값 해석에 주의하세요.

- SIGMOID는 각 클래스가 독립적이므로 여러 클래스가 동시에 1에 가까울 수도 있습니다.

- SOFTMAX는 각 클래스 확률의 합이 1이므로 여러 클래스가 동시에 높은 확률을 가지지 않습니다.

- 모델 설계에 맞게 선택하세요.

- 잘못된 함수를 쓰면 학습이 잘 되지 않거나 결과가 이상할 수 있습니다.

SOFTMAX와 SIGMOID의 차이점을 쉽게 이해할 수 있게 풀어보았습니다. SOFTMAX는 여러 가지 중 하나를 고를 때, SIGMOID는 두 가지 중 하나를 고를 때 쓰인다는 점이 가장 큰 차이입니다. 앞으로 딥러닝이나 인공지능 공부를 할 때 이 두 함수를 헷갈리지 않고 잘 쓰실 수 있기를 바랍니다.

'IT 알아가기' 카테고리의 다른 글

| IT 용어 정리_서버와 클라이언트 차이점 (9) | 2025.07.10 |

|---|---|

| GAN과 VAE 차이점 쉽게 배우기: 생성 모델을 이해하는 방법 (0) | 2025.07.03 |

| 과대적합과 과소적합 차이점 쉽게 이해하기: AI 머신러닝 용어 총정리 (0) | 2025.07.02 |

| 강화학습과 지도학습 차이점 완벽 비교: AI 공부 쉽게 이해하기 (3) | 2025.07.01 |

| 오픈소스와 상용소스 차이점 쉽게 이해하기 – 어떤 소프트웨어를 써야 할까요? (2) | 2025.04.17 |